„Der moralische Fortschritt: Wie die Wissenschaft uns zu besseren Menschen macht“. Der Buchtitel verspricht Großes. Hier wird eine zentrale Bastion abendländischen Denkens geschleift.

Es geht um das Buch „The Moral Arc“ von Michael Shermer. Die deutsche Ausgabe ist in Vorbereitung und trägt den eingangs zitierten Titel.

Shermer unternimmt nichts Geringeres als einen Angriff auf das Gesetz von David Hume, demgemäß nicht vom Sein auf das Sollen geschlossen werden kann, dass also aus den Tatsachen noch keine Entscheidungen folgen. Auch Immanuel Kant kommt unter die Räder, der den Bereich der Wissenschaft (Was kann ich wissen?) sauber vom Bereich der Werte, Normen und Moralvorstellungen (Was soll ich tun?) trennt.

Diese in unserer Kultur durchaus gefestigte Ansicht von den „getrennten Reichen“ zu widerlegen, das ist Shermers Anliegen. Es sei die Wissenschaft, die den moralischen Fortschritt vorantreibt. Zwischen Sein und Sollen bestehe ein ursächlicher Zusammenhang.

Beginnen wir mit einer Begriffsklärung. Gemäß Duden steht Moral für

- Gesamtheit von ethisch-sittlichen Normen, Grundsätzen, Werten, die das zwischenmenschliche Verhalten einer Gesellschaft regulieren, die von ihr als verbindlich akzeptiert werden

- sittliches Empfinden, Verhalten eines Einzelnen, einer Gruppe; Sittlichkeit

Nach welchem Maßstabe wird die Moral besser?

Der Prolog von Shermers Buch enthält den entscheidenden Satz: Verbesserungen im Bereich der Moral offenbaren sich in vielen Lebensbereichen. So meint er. Es folgt eine Liste von Beispielen: Der Aufstieg liberaler Demokratien, Eigentumsrechte und freier Handel, Freiheitsrechte, Wohlstand, Gesundheitswesen, weniger Kriege, Abschaffung der Sklaverei, Rückgang der Raten von Mord, Vergewaltigung und sexueller Belästigung, Abschaffung von Folter und Todesstrafe, Gleichheit vor dem Gesetz.

Aber Hoppla! Wie lassen sich Verbesserungen im Bereich der Moral feststellen, wenn nicht nach Maßgabe einer Moral? Das sieht nach einem Zirkelschluss aus. Oder aber im Buch wird eine moralische Festlegung vorab getroffen, und zwar nicht getrieben durch die Wissenschaft.

Immanuel Kant nennt einen solchen Bezugsrahmen für die praktischen und konkreten Normen und Gesetze die „oberste Bedingung aller Maximen“: „Der Gedanke a priori von einer möglichen allgemeinen Gesetzgebung […] wird, ohne von Erfahrung oder irgend einem äußeren Willen etwas zu entlehnen, als Gesetz unbedingt geboten.“ (Kant, Kritik der praktischen Vernunft, § 7 Grundgesetz der praktischen Vernunft)

Michael Shermer denkt wohl, seine wissenschaftsgetriebene Moral sei ein solcher Rahmen. Er erkennt an, dass es Alternativen dazu gibt; sie sind der Philosophie entlehnt: die Nikomachische Ethik des Aristoteles, der kategorische Imperativ des Immanuel Kant, der Utilitarismus des John Stuart Mill und die Theorie der Gerechtigkeit von John Rawls.

Beim näheren Hinsehen aber bietet die wissenschaftsgetriebene Moral gar keinen Maßstab in diesem Sinne. Dazu ist sie viel zu vage und zirkelhaft („Was die Vernunft uns gebietet ist vernünftig“). So gesehen bleibt die Bewertung dessen, was ein Fortschritt ist, eine Geschmacksfrage. Und in diesem Fall ist es der Geschmack des Michael Shermer. Michael Shermer hat – wie viele andere auch – ein Mitgefühl für Tiere; er mag die Jägerei, die Fischerei und das Schlachten von Tieren nicht. Die wachsende Population der Vegetarier ist für ihn folglich ein positiver moralischer Trend.

Dass man die Veredelung in der Landwirtschaft — Verfütterung von Feldfrüchten mit dem Zweck des Fleischkonsums — auch aus Gründen des ökonomischen Umgangs mit den Ressourcen ablehnen kann, spielt für Shermer nur eine untergeordnete Rolle. Dabei hätte er hier noch am ehesten seine wissenschaftlich-wirtschaftlichen Argumente anbringen können.

Vergessen wir den Anspruch, die moralischen Normen wissenschaftlich zu begründen und nehmen wir sie als das, was sie sind: Unbedingte Setzungen, mehr oder weniger nützlich und jedenfalls diskussionswürdig. Wirksamkeit erlangen solche moralische Prinzipien in einem demokratischen Entscheidungsprozess; sie verwirklichen sich letztendlich in unseren Gesetzen.

Shermers Buch hat dazu einiges von Belang zu bieten. Es fasst moralische Prinzipien in Art der Zehn Gebote zusammen. Die folgende Kurzfassung soll Lust darauf machen, sie im Original zu studieren. Ich ziehe den Hut vor dem, der sie zur Richtschnur seines moralischen Verhaltens macht.

- Alles nun, was ihr wollt, dass euch die Leute tun sollen, das tut ihnen auch!

- Frage erst nach, ob deine Aktion vom anderen als gut oder schlecht empfunden wird.

- Strebe nach Glückseligkeit und denke dabei auch an die anderen.

- Suche die Freiheit und denke dabei auch an die Freiheit der anderen.

- Handle fair.

- Handle möglichst rational.

- Übernehme die Verantwortung für dein Handeln.

- Verteidige auch andere gegenüber moralischen Aggressoren.

- Dehne deine moralischen Kategorien auch auf Leute anderer Nationen und anderer Religionen, auf Leute anderer Hautfarbe oder anderer sexueller Orientierung aus.

- Leiste deinen Beitrag zum Weiterbestehen der gesamten Biosphäre.

Für das Reziprozitätsprinzip (1.) habe ich die Formulierung aus Mt 7, 12 gewählt; diese Anleihe bei der Bibel passt nicht so recht zu Shermers Behauptung „religion cannot be the driver of moral progress“. Die Erweiterung des Reziprozitätsprinzip (2.) berücksichtigt die Tatsache, dass Risikobewertungen subjektiv sind. Das 3. Prinzip kommt aus der Antike zu uns (Epikur). Zum Freiheitsprinzip (4.) hat John Stuart Mill einen berühmten Aufsatz geschrieben und er bezieht sich darin auch auf antike Wurzeln. Das Fairnessprinzip (5.) wurde von John Rawls klar gefasst.

Das Vernunftprinzip (6.) stößt mir auf, denn wer gibt schon zu, irrational zu handeln. Außerdem steht nach Shermer alles moralische Handeln unter dem Regime der Vernunft. So gesehen steht hier: es ist vernünftig, vernünftig zu sein. Das 7. Gebot, dem ich gerne zustimme, entstammt der Verantwortungsethik und steht im Gegensatz zu Kants Gesinnungsethik. Aus dem letzten Prinzip (10.) kann man mit etwas Mühe die heute international akzeptierte Forderung nach nachhaltiger Ressourcennutzung herauslesen.

Das alles ist nicht alternativlos. Jedenfalls ist dieser Dekalog nicht zwangsläufige Folge irgendwelcher wissenschaftlicher Theorien. Diese Prinzipien lassen sich nicht aus Fakten ableiten.

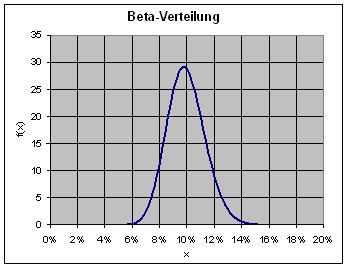

Besonders sticht mir das 2. moralische Prinzip dieses Dekalogs ins Auge. Hier spielt tatsächlich die Wissenschaft eine Rolle. Es geht um die Erkenntnisse der Risikoforschung. Dennoch bleibt es eine Setzung – bedingungslos. Warum das so ist, weiß ich aus eigenem Erleben.

Vor über zwei Jahrzehnten bin ich, ohne das zu wissen, dem 2. Prinzip gefolgt und habe in Ingenieurkreisen ziemlich vehement vertreten, dass die Risikobewertung vom Standpunkt der Betroffenen auszugehen habe, dass sie unvermeidlich subjektiv sei. Darin bin ich der Linie der Prospect Theory von Daniel Kahneman und Amos Tversky gefolgt.

Ich hatte damals einen schweren Stand gegenüber einigen Vertretern der Industrie (Kerntechnik, Bahnwesen), die damals noch das objektive Risiko als das geeignetere Maß ansahen. Sie hätten anstatt des zweiten Prinzips wohl lieber einen Satz von Albert Kuhlmann vom TÜV Rheinland gesehen: „Die Sicherheitskultur muss sich darum bemühen, dass es zu einer Vergleichmäßigung der technischen Risiken kommt.“ Damit ist die „Verteilung der technischen Risiken auf die Gesellschaft und den einzelnen Bürger“ nach objektiven Maßstäben unter Zugrundelegung des technisch-naturwissenschaftlichen Risikobegriffs gemeint.

Korrelation

Die Moral sei mit der Zeit immer besser geworden, so Shermer. Er begibt sich ins Archiv der Weltgeschichte, ist dort außerordentlich fleißig und trägt einen Berg von Belegen zusammen zur Stützung dieser These.

Shermer schreibt die von ihm konstatierte Verbesserung der Moral dem gleichlaufenden Fortschritt von Wissenschaft und Vernunft zu, wobei die Rolle der Vernunft darin bestehe, rationale Argumente und empirische Belege zu liefern – was nun wiederum auf Wissenschaft hinausläuft.

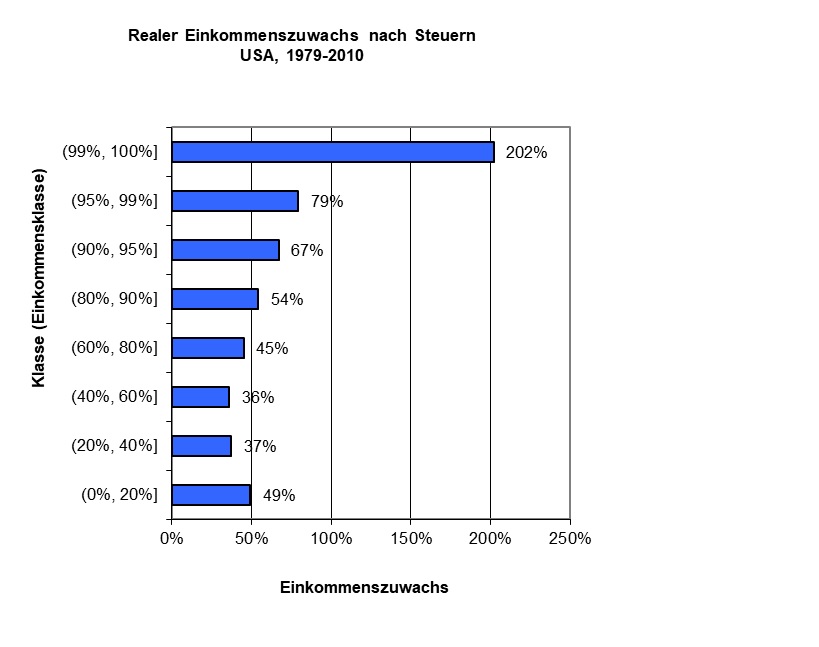

Seine Auswahl an Beispielen für diesen Zusammenhang ist tendenziös. Ich greife eins heraus: Die USA sind Spitze bei der Zahl der Nobelpreisträger, in punkto Religiosität und hinsichtlich der Mordrate. Sie können leicht erraten, welche der drei möglichen Paarungen Eingang ins Buch gefunden hat: Religiosity and Homicides (Bild 4-2 auf Seite 170).

Bereits der These vom Fortschritt der Moral muss man mit Skepsis begegnen. Dass mit dieser Prämisse möglicherweise etwas nicht stimmt, zeigen die aktuellen politischen Tendenzen in den USA sowie in Ost- und Südeuropa: Fremdenfeindlichkeit und die damit einhergehende Demontage des Toleranzgebots.

Letzteres ist nicht etwa das Werk von Wissenschaftsskeptikern. Technik- und Wissenschaftsgläubige sind am Werk. Ayn Rand verleiht diesen Leuten eine mächtige Stimme; von ihr kommt der flammendste Angriff auf einen der wichtigsten Grundwerte unserer westlichen Gesellschaften, auf die Toleranz.

Zu denken gibt auch der Satz, den der Internetkritiker Jaron Lanier im Spiegel-Interview am 3.11.2018 zum Besten gegeben hat: „All die Eltern, die bei Google und Facebook arbeiten, erlauben ihren Kindern nicht, die Produkte zu benutzen, die sie selbst entwerfen.“ Auch die Verrohung der Sitten in den sozialen Netzwerken dient schwerlich der Stützung von Shermers These von der andauernden Verbesserung der Moral.

Nähern wir uns dem Problem von einer anderen Seite. Die Steinzeitfrau war an Herd und Kind gebunden. Die Arbeitsteilung zwischen Mann und Frau war durch biologische und wirtschaftliche Gegebenheiten ziemlich starr vorgegeben. Gleichstellungsbestrebungen lagen nicht in der Luft. Deshalb waren die damaligen Menschen nicht weniger moralisch als die heutigen.

Die Technik befreit weitgehend von der Hausarbeitsfron. Frauen in der Wirtschaft sind ein lohnendes Geschäft für die gesamte Gesellschaft. So kam es dann auch zu unseren Gleichstellungsgesetzen.

Das Beispiel zeigt: Die Wissenschaft bringt die Technik voran. Diese führt zum gesellschaftlichen Wandel und dieser wiederum zu einer Entwicklung der Normen, die den sich ändernden Lebensverhältnissen gerecht werden. Wie bereits Karl Marx feststellte: Erst ist die Basis da, dann kommt der kulturelle Überbau mit seinen Standards.

Kausalität

So gesehen hat die Wissenschaft keinen direkten Einfluss auf die Moral. Von besser oder schlechter kann nicht die Rede sein. Zu fragen ist nur, inwieweit ein System von Normen zu den Gesellschaftsverhältnissen passt. Und natürlich gibt es Rückwirkungen des Überbaus auf die Produktionsverhältnisse, auf die Basis. Eine einfache Ursache-Wirkungsbeziehung von der Wissenschaft hin zu den gesellschaftlichen Normen ist nicht auszumachen.

Aber genau um einen solchen Nachweis geht es Michael Shermer. Fast zwanghaft trägt er einen riesigen Berg an Beispielen zusammen, in denen es immer darum geht, den Einfluss der Wissenschaft auf das moralische Wachstum zu belegen. Aber es bleibt bei der ständig wiederholten Behauptung. Ursache-Wirkungsbeziehungen bleiben unsichtbar. Bestenfalls werden Korrelationen belegt.

Shermers Argumentationsmuster hat durchgängig die Form A → B, wobei A für die Wissenschaft, B für immer neue Beispiele moralischen Wachstums und der Pfeil für die Wirkungsrichtung steht. Dabei gerät in Vergessenheit, dass die Korrelation zwischen A und B durchaus auch von Kausalbeziehungen C → A und C → B erzeugt sein kann. Manchmal verrät Shermer auch, wie die gemeinsame Ursache C aussehen könnte.

Er ist sich offenbar der Tatsache bewusst, dass seine Beteuerungen auf schwachen Füßen stehen. Er schreibt nämlich, dass die wachsende Fähigkeit des abstrakten Denkens C sowohl die Wissenschaft A als auch die Moral B vorangebracht haben könnte.

Allzuviele Beispiele ermüden. Ich greife nur noch eines heraus.

Shermer stellt sicherlich zu Recht fest, dass der aufstrebende Handel C die Regeln der Fairness B nach sich gezogen hat. Der Mathematiker wird ergänzen: Und dieser freie Handel hat auch die mathematischen Wissenschaften A beflügelt; er hat die Wahrscheinlichkeitsrechnung aus der Spielerecke gezerrt und für die Statistik und das Versicherungswesen nutzbar gemacht (Bernstein, 1996). Die moralischen Gebote der Fairness sind eine Folge des freien Handels und wohl kaum eine Konsequenz der mathematischen Wissenschaft.

Das zum Thema Korrelation und Kausalität.

Kommt die Wissenschaft vor der Moral?

Es stellt sich die Frage, ob die Wissenschaft wenigstens den Formulierungen der Moralvorstellungen vorausgeht. Das wäre nämlich das Mindeste, was man im Sinne der postulierten Kausalitäten verlangen müsste.

Aber auch da sieht es nicht gut aus. Ein Meilenstein der Renaissance war die Wiederentdeckung des Lehrgedichts „Über die Natur der Dinge“ von Lukrez im Jahre 1417 – vermutlich im Benediktinerkloster Fulda.

Anstelle von empirischen Belegen findet man in dem Text nur Spekulationen über den Aufbau der Welt. Spekulation und Metaphysik gehören zum kreativen Vorfeld der Wissenschaft. Wissenschaftlich im modernen Sinne ist das alles nicht. Dazu fehlen die empirischen Nachweise und Prüfungen.

Erst zweihundert Jahre nach dem Wiederauffinden und über siebzehn Jahrhunderte nach Entstehung des Lehrgedichts entstand die moderne Erfahrungswissenschaft durch Loslösung der scientia von der sapientia. Auf diese scientia beruft sich Shermer, wenn er von science spricht.

Dennoch handelt es sich bei dem Lehrgedicht und dessen Auferstehung um einen Schatz von außerordentlichem Wert – und das nicht etwa wegen der Auswirkung auf die Wissenschaft, sondern wegen seiner umwälzenden Wirkung in Sachen Moral, Normen und Wertvorstellungen. Um das zu verdeutlichen, folgen ein paar kurze Auszüge aus dem Lehrgedicht (übertragen von Klaus Binder).

- … ich eile, die Seele aus den bindenden Fesseln des Aberglaubens zu lösen. (1.932)

- Dass ihr nicht seht, was die Natur verlangt, nicht mehr nämlich, als dass Schmerzen weit ferngehalten werden vom Leib und der Geist sich, von Sorge erlöst und Furcht, heiter fühle und gelassen! (2.19)

- Weil weder Reichtum noch Rang noch Pomp der Macht irgend heilsam wirken auf den menschlichen Leib, darum, so können wir annehmen, sind sie unnütz für Geist und Seele. (2.39)

- Gäbe es keinerlei Abweichung der Urelemente, die durch neu gerichtete Bewegung das Gesetz des vorbestimmten Schicksals sprengt, dann wäre seit unendlicher Zeit in endloser Kette Ursache auf Ursache gefolgt. Woher aber, frage ich, hätten dann lebende Wesen überhaupt auf Erde den freien Willen? (2.255)

- Gering sind die Spuren unserer natürlichen Anlagen, die vernünftigem Denken widerstehen und bleiben. Nichts also hindert uns, ein Leben zu führen, das Göttern würdig ist. (3.320)

- Es ist die Natur der Dinge nicht durch göttliches Wirken geschaffen und auch nicht für uns. (5.195)

Soweit Lukrez, aber das ist längst nicht alles, was die Antike uns an Wertvorstellungen zu bieten hat. Demokratie, Freiheit, Individualismus, all dies heute wirksame normsetzende Gedankengut der Antike wurde uns von jüdischen, islamischen und christlichen Gelehrten und Schreibern übermittelt und wurde teils für Jahrhunderte in Klosterbibliotheken aufbewahrt. Das alles geschah in vorwissenschaftlicher Zeit, in eine Zeit also, in der das Nachdenken über die Natur die Metaphysik hervorbrachte und in der diese Spekulationen Teil der Philosophie waren.

Aus vorwissenschaftlicher Zeit sind auch die Grundregeln der Skepsis, die der jüdische Philosoph Moses Maimonides formuliert hat. Es sind die Aufforderung zur Toleranz gegenüber Gesprächspartnern und der abgewogene Zweifel. Diese Grundregeln der Gesprächskunst haben normative Geltung (Basics für Skeptiker).

Kurz gefasst

Michael Shermer, Begründer der Skeptics Society und Herausgeber des Skeptic-Magazins, ist es gelungen, eine ganze Reihe von Regeln gesunder Skepsis zu brechen. Das nenne ich „gelebte Ironie“.

Dennoch: Das Buch enthält viel Bedenkenswertes und sogar Beherzigenswertes. Es lohnt die Lektüre, auch wenn es sein Hauptziel nicht erreicht, nämlich den Nachweis, dass die Wissenschaft die Moral verbessert. Das Gesetz von Hume wird nicht ausgehebelt.

Quellen

Bernstein, Peter L.: Against the Gods, 1996

Grams, Timm: Risikooptimierung kontra Risikobegrenzung. Analyse eines alten und andauernden Richtungsstreits. Automatisierungstechische Praxis atp 8/2003

Greenblatt, Stephen: The Swerve. How the World Became Modern. 2011

Höffe, Otfried: Aristoteles: Die Hauptwerke. Ein Lesebuch. Tübingen 2009

Lukrez: Über die Natur der Dinge. (In deutsche Prosa übertragen und kommentiert von Klaus Binder. Mit einer Einführung von Stephen Greenblatt. 2014)

Maimonides, Moses: Wegweiser für die Verwirrten. Eine Textauswahl zur Schöpfungsfrage. 2009

Mill, John Stuart: On Liberty and Utilarianism. Oxford University Press 1969

Shermer, Michael: The Moral Arc. How Science Makes Us Better People. 2015