Im ersten Teil von „Denksport am Rande des Wahnsinns“ ging es um Mathematik in der Schule, speziell um die vollständige Induktion und um Optimierungsaufgaben. Im zweiten Teil suche ich nach Antworten auf die Frage, was es mit dem Grundstoff der Mathematik, mit den Zahlen, auf sich hat.

Die Welt der Zahlen

Die größte Zahl

Der Name der größten Zahl stammt von einem Kind. Sein Onkel, ein Mathematiker, hatte die Zahl an die Tafel geschrieben und das Kind meinte, dass das wie ein Googol aussehe. Unter Beteiligung von etwas Legasthenie wurde daraus später der Name der heute beliebtesten Suchmaschine im Internet. Wen die ganze Geschichte interessiert, der möge diese Suchmaschine bemühen oder in „Eine kleine Geschichte der Unendlichkeit“ von Brian Clegg nachsehen (2015, S. 57).

Im Alltagsleben kommt man immer mit deutlich kleineren Zahlen aus. Dem Googol kommt mit Fug und Recht das Prädikat zu, die größte Zahl zu sein. Und wie groß ist nun ein solches Googol? Jedenfalls ist es größer als die Anzahl der Atome im Universum. Ein Googol ist eine Eins gefolgt von einhundert Nullen: 10.000.000.000.000.000.000.000.000.000.000.000.

000.000.000.000.000.000.000.000.000.000.000.

000.000.000.000.000.000.000.000.000.000.000

Linien bestehen aus Punkten, oder?

Jede Strecke besteht aus Punkten. Soweit herrscht Einvernehmen. Aber: Wie viele sind es? Jetzt ist es mit der Einigkeit vorbei. Nähern wir uns der Angelegenheit ganz vorsichtig, indem wir mit dem Vergleichen beginnen,

Wir sprechen beim Umfang oder bei der Größe von Mengen besser von Mächtigkeit, wenigstens sobald wir den Bereich der endlichen Mengen verlassen. Zwei Mengen haben dieselbe Mächtigkeit, wenn es eine Eins-zu-eins-Abbildung zwischen ihren Elementen gibt. Haben die Mengen nur endlich viele Elemente, dann ist die Mächtigkeit gleich der Anzahl dieser Elemente. Die Menge {A, B, C} hat die Mächtigkeit 3, genauso die Menge aus einem Apfel, einer Birne und einer Zitrone. Nimmt man zu einer solchen endlichen Menge ein weiteres Element hinzu, erhöht sich deren Mächtigkeit um eins.

Nehmen wir die Menge der natürlichen Zahlen, dann kann man ein weiteres Element hinzufügen und es entsteht eine Menge derselben Mächtigkeit: Nach wie vor lassen sich alle Elemente abzählen, zum Beispiel so: 1 ist die Nummer des hinzugefügten Elements, 2 die Nummer für die 1, 3 die Nummer für die 2 usw. Es gibt also eine Eins-zu-eins-Abbildung zwischen der Menge der natürlichen Zahlen und der neu gebildeten Menge mit einem zusätzlichen Element.

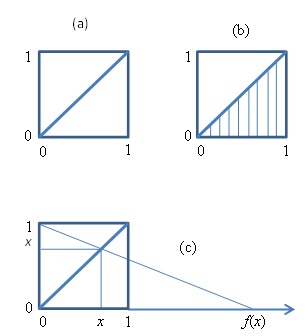

Wir vergleichen zwei Strecken. Nehmen wir eine Seite des Einheitsquadrats und vergleichen diese mit der Diagonalen, Bild (a). Es gibt eine Eins-zu-eins-Abbildung von allen Punkten der einen Strecke zu denen der anderen, wie in Bild (b) angedeutet. Die Punktmengen der Strecken haben folglich dieselbe Mächtigkeit, obwohl die Strecken offensichtlich ungleich lang sind (Lietzmann, 1962, S. 120). Der Wahnsinn schimmert auf.

Wir vergleichen zwei Strecken. Nehmen wir eine Seite des Einheitsquadrats und vergleichen diese mit der Diagonalen, Bild (a). Es gibt eine Eins-zu-eins-Abbildung von allen Punkten der einen Strecke zu denen der anderen, wie in Bild (b) angedeutet. Die Punktmengen der Strecken haben folglich dieselbe Mächtigkeit, obwohl die Strecken offensichtlich ungleich lang sind (Lietzmann, 1962, S. 120). Der Wahnsinn schimmert auf.

Bild (c) zeigt, dass die Menge der Punkte von 0 bis 1 dieselbe Mächtigkeit hat, wie die Menge der Punkte von 0 bis unendlich. Eine Funktion, die jedem Zahlenwert des Intervalls von 0 bis 1 umkehrbar eindeutig einen Wert des positiven Zahlenstrahls zuordnet, ist f(x) = x/(1-x).

Die Punkte zeigen hier ihre unheimliche Seite. Sie sind unendlich klein, sie entziehen sich der Anschauung; wir nennen sie Infinitesimale. Es ist kein Wunder, dass man sie über Jahrhunderte hinweg möglichst ignorierte und schließlich sogar verbot, sich mit ihnen in der Lehre zu befassen. Weiterlesen

Wenn ich mich recht erinnere, stand vor Jahren im Café Chaos an der Hochschule Fulda eine Lampe, getragen von einem Mohr (so sagte man vor langer Zeit). Das Teil zeugt nicht von feinem Geschmack; aber besonders anstößig fand es damals auch keiner. Bis Noah Sow zu einer Lesung kam. Sie reiste sofort wieder ab. Das Angebot, das Corpus Delicti zu entfernen, konnte sie nicht beruhigen. (Das Bild hat Noah Sow anlässlich ihres Besuches gemacht.)

Wenn ich mich recht erinnere, stand vor Jahren im Café Chaos an der Hochschule Fulda eine Lampe, getragen von einem Mohr (so sagte man vor langer Zeit). Das Teil zeugt nicht von feinem Geschmack; aber besonders anstößig fand es damals auch keiner. Bis Noah Sow zu einer Lesung kam. Sie reiste sofort wieder ab. Das Angebot, das Corpus Delicti zu entfernen, konnte sie nicht beruhigen. (Das Bild hat Noah Sow anlässlich ihres Besuches gemacht.)