Dies ist ein Fallbericht. Er zeigt, wie der Neue Atheismus (GBS, Brights) weltanschaulich pluralistische oder neutrale Vereine und Verbände mit säkular-laizistischer Grundhaltung (GWUP, HVD) unterwandert und dabei totalitäre Strukturen aufbaut. Das habe ich erst in den letzten Wochen klar erkannt, obwohl ich durch den Spiegel-Artikel Der Kreuzzug der Gottlosen von 2007 hätte vorgewarnt sein müssen. Aber ich habe den Ausriss erst jetzt, anlässlich der Recherchen, in meinem Exemplar des Richard-Dawkins-Werkes „The God Delusion“ wiederentdeckt.

Die GWUP öffnet sich der atheistischen Mission

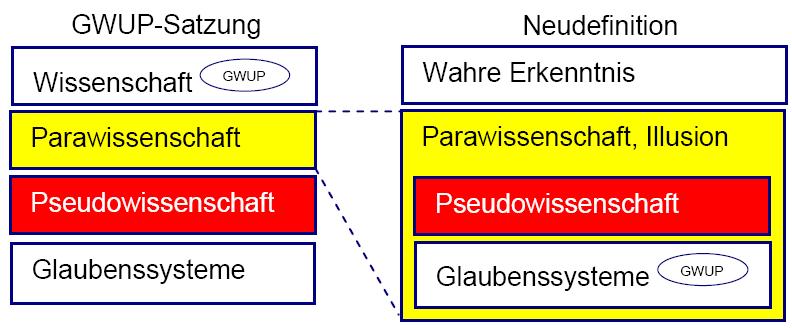

Eine offizielle Informationsschrift der Gesellschaft zur wissenschaftlichen Untersuchung von Parawissenschaften (GWUP) hat den Titel „Parawissenschaft – Pseudowissenschaft“ (Martin Mahner, 5.1.2010). Sie steht im Widerspruch zur gültigen GWUP-Satzung.

Es geht um eine Ausweitung des Arbeitsfeldes der GWUP. Die entscheidende Grenze für die GWUP soll danach nicht länger zwischen Wissenschaft und Nichtwissenschaft verlaufen, sondern zwischen Erkenntnis und Illusion (Martin Mahner in „Was sind Parawissenschaften?“, skeptiker 4/2009, S. 186-190). Auch Metaphysik und Religionen sollen demnach in das Zielgebiet der GWUP fallen.

Auf der Mitgliederversammlung 2014 in München (traditionell am Freitag nach Himmelfahrt) stellte ich einen Antrag, in dem der Vorstand aufgefordert wird, die Widersprüche zwischen offiziellen Verlautbarungen und Satzung zu beseitigen und insbesondere die Neudefinition „Parawissenschaft – Pseudowissenschaft“ zurückzuziehen.

In der Versammlung wurde der Wunsch nach einer gründlichen Diskussion laut. Die Entscheidung wurde auf das Folgejahr vertagt, also auf Himmelfahrt 2015.

In diesem Jahr, am Freitag nach Himmelfahrt, lag der Mitgliederversammlung ein Beschlussvorschlag des Vorstands zu einer Satzungsänderung vor. Dieser bezweckt eine Ausweitung und Aufweichung des Vereinszwecks derart, dass die GWUP-Informationsschrift und die Ausweitung des GWUP-Arbeitsfeldes nun satzungskonform sind. In der Begründung dieses Antrags spielte die von mir kritisierte Informationsschrift keine Rolle, stattdessen wurden ein paar, im Grunde haltlose, Argumente vorgeschoben. Es ging also nicht mehr darum, sich nach der Satzung zu richten, sondern darum, die Satzung so zu ändern, dass die Informationsschrift dann satzungskonform ist.

Die Möglichkeit, neben der Esoterik auch die Religionen aufs Korn zu nehmen, wird damit ausdrücklich eröffnet. Offenbar besteht die Absicht, die GWUP zu einer Einrichtung der atheistischen Missionierung umzubauen.

Giordano-Bruno-Stiftung und Brights

Zweifel an dieser Zielsetzung verfliegen, wenn man sich das Personal, die in prominenter Stellung Handelnden, ansieht. Es folgt ein Auszug aus der Besetzungsliste.

Martin Mahner, Verfasser der GWUP-Informationsschriften, ist Hausphilosoph der GWUP und zugleich Beirat der Giordano-Bruno-Stiftung (GBS). Amardeo Sarma, Vorsitzender der GWUP, gibt sich als Mitglied der GBS zu erkennen. Viele Anhänger der GBS sind gleichzeitig Anhänger oder Mitglieder der Brights.

Eine Schlüsselfigur des noch zu schildernden einjährigen „Diskussionsprozesses“ von Himmelfahrt 2014 bis Himmelfahrt 2015 ist Rainer Wolf. Er ist sowohl Mitglied im Vorstand und dort zugleich Repräsentant des Wissenschaftsrats der GWUP als auch Mitglied der Brights. Rainer Rosenzweig, ehemals Doktorand von Rainer Wolf, ist Mitglied im Wissenschaftsrat der GWUP und im Beirat der GBS.

Die GBS als auch die Brights missionieren aggressiv für den Neuen Atheismus in der Gefolgschaft von Richard Dawkins („The God Delusion“, 2006). Die Ziele und Methoden dieser Vereinigungen sind mit den Grundsätzen eines weltanschaulichen Pluralismus unverträglich. Im Hoppla!-Artikel „Die Giordano-Bruno-Stiftung (GBS): nur wirr oder gar gefährlich?“ habe ich ein paar Bemerkungen dazu gemacht.

Das Büchlein „Manifest des evolutionären Humanismus“ von Michael Schmidt-Salomon aus dem Jahre 2005 bildet die „philosophische“ Grundlage der GBS. Die Absicht dahinter wird schnell klar: Jeder liberale Geist soll sich darin irgendwo wiederfinden können. Nur nachdenken darf er dabei nicht. Der Text ist, wie der ihm zugrundeliegende ontologische Naturalismus mahnerscher Prägung, von haarsträubender Oberflächlichkeit. Dazu strotzt er vor inneren Widersprüchen. Hier nur zwei weitere Beispiele.

Erstens: Der auf Seite 37 angesprochene Falsifikationismus des Karl Raimund Popper ist eng verbunden mit dessen „Sozialtechnik der Einzelprobleme“ (aus: „Die offene Gesellschaft und ihre Feinde“). Das großsprecherische 10. (An‑)Gebot des Evolutionären Humanismus auf S. 158 steht im unversöhnbaren Gegensatz dazu: „Stelle Dein Leben in den Dienst einer ‚größeren Sache‘“. Aus diesem Satz spricht Totalitarismus, also das Ziel, „ein umfassendes neues Wertsystem durchzusetzen“ (Brockhaus). Nichts lag Popper ferner.

Zweitens: Auf S. 94 wird der naturalistische Fehlschluss angesprochen, nach dem man das Sollen, das sind die moralischen Gesetze, aus dem Sein, den Naturgesetzen also, herleiten könne. Obwohl das Scheitern dieses Programms zugestanden wird, versucht Schmidt-Salomon einige Seiten später (S. 120 ff.) genau das: Die Etablierung einer humanistischen Ethik auf der Basis von Vernunft und Naturverständnis. Der Präferenzutilitarismus des Peter Singer wird geradezu als Denknotwendigkeit angeboten.

Kürzlich wurde selbst Schmidt-Salomon ob der Wahl des Peter Singer zur Leitfigur unheimlich zumute.

Für Joachim Kahl vom HVD sind die zehn Angebote des evolutionären Humanismus ein Türöffner der Beliebigkeit (Fürther Streitgespräch vom 27.06.2006). Allmählich spricht sich herum, wie dürftig das Angebot des evolutionären Humanismus der GBS ist.

Missionsgebiete: GWUP und HVD

Weltanschaulich pluralistische und eher dem Diesseits zugewandte Vereinigungen wie der Humanistische Verband Deutschlands (HVD) und die Gesellschaft zur wissenschaftlichen Untersuchung von Parawissenschaften (GWUP), die gut ohne derartige Metaphysik auskommen, gehören zum Missionsgebiet der Neuen Atheisten. Auch wenn der HVD eine säkular-laizistische Gesellschaft zum Ziel hat und den politische Einfluss der Kirchen zurückdrängen will, heißt das noch lange nicht, dass in die dann vermeintlich entstehende Lücke eine andere Religion, eine in der Gestalt des Neuen Atheismus, hineingestopft werden muss.

Der zunehmende Einfluss der Neuen Atheisten auf den HVD wird ersichtlich, wenn man das 2011 verfasste „Humanistische Selbstverständnis“ des HVD mit den im Jahr darauf publizierten „Humanistischen Grundsätzen“ des HVD Bayern vergleicht: Das erstgenannte Papier ist weitgehend frei vom ideologischen Gedankengut der Neuen Atheisten. In dem zweiten verrät sich deren Einfluss durch typischen Naturalisten-Sprech: „Es geht überall mit rechten Dingen zu“, „Humanisten sind Naturalisten“ und dergleichen mehr.

Einen Großteil des Einflusses erreichen die neuen Atheisten durch Personalunion. Im Falle der GWUP leisten das die Herren Sarma, Mahner, Rosenzweig und Wolf. Dazu kommen die Philosophen Gerhard Vollmer und Bernulf Kanitscheider, die sowohl Mitglieder des GWUP-Wissenschaftsrats als auch des GBS-Beirats sind. Das sind nur die Personen, deren Zugehörigkeiten ich zweifelsfrei kenne.

Die GWUP-interne „Diskussion“ zur Satzungsänderung zeigt, wie die Neuen Atheisten ihren Einflussbereich ausweiten. Mit offenen, wissenschaftsorientierten Diskussionen hat das nichts zu tun. Es läuft nach dem Motto: Wir sind die Aufgeklärten, die Brights, wir haben Recht, und deshalb heiligt der Zweck die Mittel.

Um bereits jetzt unangebrachten Vorwürfen zu begegnen: Auf den monatlichen Treffen der Würzburger GWUPler habe ich immer wieder betont: Mein Untersuchungsgegenstand ist nicht die Homöopathie, auch nicht Astrologie oder Wünschelrutengängerei; mein Interesse gilt seit einiger Zeit der GWUP, ihren inneren Strukturen und ihrer Diskussionskultur.

Eine „Diskussion“ mit Glaubenskämpfern

Ein Jahr lang, von Himmelfahrt 2014 bis Himmelfahrt 2015, fand eine bemerkenswerte „Diskussion“ zum Thema Satzungsänderung statt. Sie ist wesentlich durch die totalitäre Grundhaltung der GBS-Leute innerhalb der GWUP geprägt.

In diesem Diskussionsprozess nahm ich einige Demütigungen in Kauf, denn ich hatte ein Ziel vor Augen, nämlich den Strukturen der GWUP näher zu kommen. Ich stelle ein paar Wesenszüge des Prozesses heraus. Eine Schlüsselfigur ist Rainer Wolf.

1. Kompromisslosigkeit. Sie ist eine Eigenschaft aller Glaubenskämpfer und kommt hier nicht überraschend. Der harte und nicht anzweifelbare Glaubenskern wird durch ein gefälliges Drumherum versüßt. Man darf sich durch die verbalen Schleifchen nicht täuschen lassen: „Deine kritischen Überlegungen kann ich sehr gut nachvollziehen, und ich glaube, sie treffen ganz Wesentliches. Drei Punkte sehe ich, wo ich wohl etwas anders denke …“ Oder so: „Auch wenn ich nicht allen Formulierungen von Michael Schmidt-Salomon zustimme, ist er doch einer der wenigen Philosophen …“ Oder so: „Wir schließen die Festlegung auf eine Weltanschauung aus“ und gleichzeitig wird alles getan, um genau eine solche Festlegung zu ermöglichen. Ein Diskurs kommt aufgrund der Ablenkung durch Strohmann- und Stellvertreter-Argumente erst gar nicht zustande.

2. Intransparenz. Mir war zu keinem Zeitpunkt klar, mit welchen Personen (Wissenschaftsrat? Vorstand?) ich es zu tun hatte und wie der Konsens unter ihnen zustande gekommen sein könnte.

3. Totalkontrolle. Einem Hinweis vom 01.08.2014 entnehme ich, dass die Lenkung der Meinungsbildung einer „kleinen Kommission“, bestehend aus Rainer Rosenzweig, Martin Mahner und Rainer Wolf übergeben worden war. So funktioniert das totalitäre Regime: Es gibt eine Kommission der Eingeweihten, in diesem Falle alles Neuatheisten; ihnen gegenüber sitzt der Delinquent, in dem Fall ich. Warum ich auf so etwas allergisch reagiere, kann man in meiner Abschiedsvorlesung im Zusammenhang mit der „Entnazifizierung eines Achtjährigen“ nachlesen.

4. Bevormundung. Manche meiner E-Mails wurden von Rainer Wolf einfach zurückgehalten. Auf Nachfrage gab er mir den Bescheid, dass damit Porzellan zerschlagen würde. Andere E-Mails wurden von Rainer Wolf mit Kommentaren versehen und erst dann an den internen Zirkel weitergeleitet. Ein Leserbrief zu einem Mahneraufsatz im skeptiker hat die Redaktion wohl erst gar nicht erreicht. Anstelle einer Eingangsbestätigung erhalte ich nur Wolfs Kommentar: „Dem Inhalt Deines Leserbriefs kann ich beim besten Willen nicht zustimmen“ (Wolf, 21.12.2014). Und das war’s dann.

5. Gutsherrenart. Mein mehrfach geäußerter Wunsch, meinen Gegenantrag genauso wie den Vorstandsantrag vorab an alle Mitglieder zu verteilen, aus Kostengründen nur per E-Mail, wurde abgelehnt mit den Worten: „Der Vorstand hat bereits nach eingehender Diskussion vor mehr als eine Woche beschlossen, Ihr Schreiben nicht per reguläre Post an alle Mitglieder zu verschicken“ (Sarma, 14.04.2015). Meine Versuche, die Mitgliedschaft doch noch direkt zu erreichen, wurden dadurch vereitelt, dass mir tote Geleise gewiesen wurden, wie beispielsweise eine vermeintliche Mailingliste der Mitglieder (Sarma, 09.04.2015). Ich musste erst mühsam lernen, dass es sich dabei um ein fluktuierendes Forum handelt, an dem immer nur wenige Mitglieder teilnehmen.

6. Autoritätsargumente. Fremde Ideen muss man schnell wieder loswerden. Wie das funktioniert? Man setzt auf das Autoritätsargument und auf Einschüchterung: „Mir liegt mittlerweile die Rückmeldung vor, dass alle Wissenschaftsräte sich einstimmig für die neue Satzung ausgesprochen haben“ (Rainer Wolf am 12.05.2015).

Ein Teilnehmer der Mitgliederversammlung 2015 kritisierte das starre Verhalten des Vorstands und empfahl, sich doch besser an dem bekannten Ausspruch zu orientieren: „Ich bin zwar anderer Meinung als Sie, aber ich würde mein Leben dafür geben, dass Sie Ihre Meinung frei aussprechen dürfen.“

Abschluss des Verfahrens

Angesichts des massiven Auftretens des Vorstands für die Satzungsänderung war mir die Chancenlosigkeit meines Widerstands seit Monaten klar. Aber ich wollte ja sehen, wie die Sache abläuft. Bis zum bitteren Ende. Immerhin gab es ein paar Mitglieder, die dem Vorstand, trotz dessen massiven Auftretens, nicht gefolgt sind. Mutig.

Nachdem der Vorstandsvorschlag von der Versammlung mehrheitlich angenommen war, gab ich eine Erklärung zu Protokoll. Darin wiederholte ich meine bereits vor einem Jahr geäußerte Auffassung, dass einem solchen Beschluss, der eine wesentliche Zweckänderung des Vereins nach sich ziehe, alle Vereinsmitglieder, ob anwesend oder nicht, zustimmen müssten. Unter diesen Bedingungen müsse der Vorstandsantrag als gescheitert gelten. Diese Stellungnahme sollte dem Amtsrichter in Darmstadt, der über die Satzungsänderung zu befinden hat, vorgelegt werden.

Daraufhin gab das Vorstandsmitglied Ralf Neugebauer, Richter am OLG Düsseldorf, zu verstehen: Das sei alles mit dem Amtsrichter vorab geklärt worden.

Auch dahinter könnte man Ungeheuerliches vermuten. Vorsichtshalber habe ich im Anschluss an die Mitgliederversammlung meine Erklärung dem Amtsgericht direkt zugeschickt. Mal sehen, was daraus wird.

Meine Erfahrung zusammengefasst: Wer sich mit den Brights oder den Vertretern der Giordano-Bruno-Stiftung anlegt, der bekommt es mit Feinden der offenen Gesellschaft zu tun.