Ein mystisches Weltbild und dessen Überwindung

In den zehn Jahre meiner Mitgliedschaft in der Gesellschaft zur wissenschaftlichen Untersuchung von Parawissenschaften (GWUP) und bei Veranstaltungen des Humanistischen Verbandes Deutschland (hvd) bin ich auf Leute gestoßen, für die sich alles nach den geltenden Naturgesetzen richtet. Dieser Standpunkt weckte meinen Widerstand und in diesen Disputen schärfte ich meinen Standpunkt: Ich habe einiges über Wunder gelernt und auch über den Zusammenhang zwischen Wundern und Kreativität.

Wie nun denkt man in Kreisen der sogenannten Skeptiker über Wunder? Inge Hüsgen und Martin Mahner schreiben am 12.11.2011: „Ein Wunder ist ein Ereignis, das der allgemeinen Erfahrung widerspricht, naturgesetzlich unmöglich ist, und daher von einer übernatürlichen Wesenheit verursacht wurde.“

Der Skeptiker-Chefreporter kennt „(unwandelbare) Naturgesetze“ (GWUP-Blog, 16. März 2014). Dieser Auffassung begegnete ich folgendermaßen: „Auch die Idee von den ‚(unwandelbaren) Naturgesetzen‘ ist letztlich Glaubenssache.“ Der Chefreporter darauf: „Klar, ich habe gleich Pause, werde mal aus dem vierten Stock springen – bin sicher, dass die Gravitation nur eine Glaubenssache ist.“ (17. März 2014)

Gemessen an solchen Grobschlächtigkeiten kommt Martin Mahner eher feinsinnig daher (Unverzichtbarkeit und Reichweite des ontologischen Naturalismus, 2007). Aber auch er kennt grundlegende und nichthinterfragbare Naturgesetzlichkeiten und nennt sie Postulate. Diese Postulate stehen für ein im Grunde statisches Weltbild.

Eine der wohl machtvollsten Begründungen für diesen, letztlich in der Zahlenmystik wurzelnden Standpunkt liefert der Nobelpreisträger Eugene Wigner. In seinem Aufsatz „The unreasonable effectiveness of mathematics in the natural sciences“ (1960) bietet er eine Rechtfertigung für Galileis berühmte Aussage, dass das Buch der Natur in der Sprache der Mathematik geschrieben sei (1623). Diese Auffassung reicht weit zurück, bis zu Platon und Pythagoras, denen man den Ausspruch „Alles ist Zahl“ zuschreibt. (Die „Philosophie der Physik“ von Norman Sieroka, 2014, gibt eine Einführung in den hier angesprochenen Themenkreis.)

Wigner bescheibt etwas, worüber wir uns nur wundern können: ein Wunder.

Erst kürzlich erschien im Spiegel (33/2015) ein Interview mit dem Nobelpreisträger Frank Wilczek. Der Nobelpreisträger meint darin: „Es ist eine grandiose Tatsache, dass wir die Natur, wenn wir ihr auf den Grund gehen, in ihrem Innersten verstehen können. Die einzige, aber zutiefst spekulative Erklärung könnte sein, dass irgendein Sternenmacher, ein Ingenieur verantwortlich ist für das Design dieser Welt.“

Aus all dem spricht ein mystisches Wissenschaftsverständnis: Es gibt ewig wahre Naturgesetze. Diese liegen großteils noch im Dunkeln, aber mit unserem Aufklärungsscheinwerfer leuchten wir immer größere Teile dieser Landschaft aus.

Das ist ein unbiologischer Standpunkt. Er erinnert an die Idee vom Intelligent Design, eine von den „Skeptikern“ gründlich verachtete Denkrichtung. Sie wird dem evolutionären Charakter der Weltbildentstehung nicht gerecht. Die Wissenschaft nahm ihren Aufschwung erst, als sie nicht mehr danach fragte, „was die Welt im Innersten zusammenhält“. Deshalb gibt es auch geistreiche Entgegnungen auf die mystische Auffassung vom Weltgefüge, beispielsweise die Antwort des Richard Hamming auf Eugene Wigner (1980). Schauen wir einmal nach, ob es ihm gelingt, das Wunder zu entzaubern.

Hammings Gegenposition hat ihre Wurzeln in der Evolutionslehre des Charles Darwin. Im Jahr 1897 formulierte der bedeutende Physiker Ludwig Boltzman die Grundidee des (später von Popper so genannten) kritischen Rationalismus: „Das Gehirn betrachten wir als den Apparat, das Organ zur Herstellung der Weltbilder, welches sich wegen der großen Nützlichkeit dieser Weltbilder für die Erhaltung der Art entsprechend der Darwinschen Theorie beim Menschen geradeso zur besonderen Vollkommenheit herausbildete, wie bei der Giraffe der Hals, beim Storch der Schnabel zu ungewöhnlicher Länge.“

In seiner Antrittsvorlesung von 1900 führte Boltzmann das weiter aus: „Nach meiner Überzeugung sind die Denkgesetze dadurch entstanden, dass sich die Verknüpfung der inneren Ideen, die wir von den Gegenständen entwerfen, immer mehr der Verknüpfung der Gegenstände anpasste. Alle Verknüpfungsregeln, welche auf Widersprüche mit der Erfahrung führten, wurden verworfen und dagegen die allzeit auf Richtiges führenden mit solcher Energie festgehalten […], dass wir in solchen Regeln schließlich Axiome oder angeborene Denknotwendigkeiten sahen.“

Wunderbares

Der Naturwissenschaftler mit mystisch begründetem Weltbild kann sich noch der Illusion hingeben, er könne Wunder als solche identifizieren. Er glaubt ja, einige der unverrückbaren Naturgesetze zu kennen. Da tut sich der kritische Rationalist mit evolutionär begründetem Weltbild schwerer. Ihm fehlt bereits der Begriff der „übernatürlichen Wesenheit“ und folglich auch die Vorstellung eines von einer solchen Wesenheit verursachten Ereignisses. Er hat kein Mittel, ein solches Ereignis von einem mit noch unbekanntem aber letztlich prüfbarem Wirkmechanismus zu unterscheiden.

Martin Mahner folgt dem einfachen Rezept des Mystikers: Wunder sind Verstöße gegen die geltenden Naturgesetze. Und was gegen die Naturgesetze verstößt, kann es nicht geben.

Meistens liegt der Naturalist und „Skeptiker“ damit richtig: Wünschelrutengängerei, Astrologie, Homöopathie, Gedankenübertragung und vieles mehr lässt sich irrtumsfrei auf diese Weise verdammen. Aber in all diesen Fällen braucht man das Argument, dass ein Verstoß gegen die momentane Wissenschaftsauffassung vorliegt, tatsächlich nicht: Bei den vorgeblichen Wundern handelt es sich um prüfbare Effekte, die sich im Laufe der Prüfung verflüchtigen, die der Prüfung also nicht standhalten. Das Argument, sie stünden im Widerspruch zu geltenden Naturgesetzen, fügt dem nichts hinzu.

Wer Wunderberichte in Bausch und Bogen durch Hinweis auf die bekannten Naturgesetze ablehnt, verliert den Blick für das Wunderbare, für interessante Anomalien, deren Untersuchung zu neuen Erkenntnissen führt. Der Kampf gegen den Wunderglauben hat, ebenso wie die Verächtlichmachung des illusionären Denkens, eine kontraproduktive Kehrseite: Man schüttet das Kind mit dem Bade aus.

Sobald wir die schwer fassbare Übernatur außer Acht lassen, wird der Zugang zum Begriff des Wunders leichter. Aus rein diesseitiger Sicht, also durchweg in unserer Erfahrungswelt angesiedelt, gibt es

- die alltägliche Wunder der Natur und des Lebens,

- die Wunder, denen bereits bekannte aber verborgene Wirkmechanismen zugrunde liegen, und es gibt

- wunderbare Erfindungen und Entdeckungen.

Ich kann mich immer noch darüber wundern, dass ein Stein zu Boden fällt, dass Flugzeuge fliegen und dass wir Naturgesetze kennen, die uns Ingenieuren erlauben, Maschinen zu bauen, die den Menschen das Leben erleichtern.

Trotz aller Fortschritte der Biologie und der Künstlichen Intelligenz bleiben die Wunder des Lebens auf geheimnisvolle Art überwältigend. Erneut hat mir das der Aufsatz „Roboter mit Ego“ von Tony Prescott (Spektr. d. Wiss. 8/2015, S. 80-85) vor Augen geführt: Es ist schon erstaunlich, wie langsam die Wissenschaft der Künstlichen Intelligenz trotz aller großartigen Verkündigungen ihrer Apologeten vorankommt.

Der 14. Vers des 139. Psalms drückt dieses Erstaunen angesichts der Wunder der ersten Art aus: „Ich danke dir dafür, dass ich wunderbar gemacht bin.“

Aber diese Wunder erster Art sind sicherlich nicht gemeint, wenn wir von Wundern sprechen: Ein Wunder ist für uns kein Wunder mehr, wenn es sich auf Alltägliches und gut Geprüftes zurückführen lässt.

Diese Rückführung ist nicht immer leicht. Manches Wunder lässt sich nicht einfach entzaubern. Schon aus diesem Grund ist es völlig daneben, von übernatürlichen Wundern zu sprechen: Wir könnten sie ja nicht von Wundern unterscheiden, die sich im Prinzip entzaubern lassen und die sich beharrlich der Entzauberung entziehen.

Bei den folgenden beiden Wundern der zweiten Art stecken hinter den wundersamen Effekten nahezu triviale Mechanismen. Man muss sie nur erkennen.

Die Masse macht’s

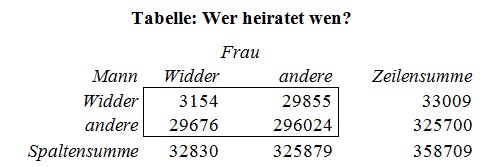

„Am 18. August 1913 gab es in Monte Carlo ein bemerkenswertes Ereignis. In dem legendären Spielcasino, in dem sich die Oberschicht halb Europas in Frack und Abendgarderobe ein Stelldichein gab, landete die Kugel des Roulette stolze sechsundzwanzig Mal hintereinander auf Schwarz“ (Frankfurter Allgemeine, 30.06.2012).

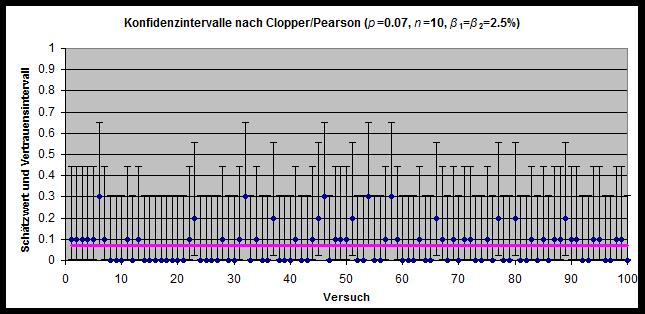

Bei vielen Gelegenheiten für ein „Wunder“ erscheint halt hin und wieder eins. Um dieses spezielle Casino-„Wunder“ zu produzieren, müssen weltweit nämlich höchstens ein paar hundert Millionen Mal die Rouletteräder gedreht werden. Sehr diesseitig ist das.

Für den mathematisch Interessierten: Die Anzahl der Spielrunden am Roulettetisch bis erstmals 26 Mal Schwarz erscheint, ist nicht allzu groß. Der Erwartungswert für die Zahl der Runden, bis ein solches Ereignis eintritt, beträgt nur 134.217.726, also etwa 134 Millionen. Bei der weltweit großen Zahl an Spieltischen ist eine solche Rundenzahl etwas durchaus Irdisches. Man sollte sich wundern, wenn ein solches Ereignis nicht irgendwann einmal eintritt (Problemsammlung Querbeet, Aufgabe 24 Zufall oder nicht?).

Verborgene Strukturen

Hier ist ein weiteres Beispiel für Trivialitäten, die sich als Wunder ausgeben. Es ist der Unterhaltungsmathematik zuzuordnen. Ich stelle Ihnen jetzt eine kleine Rechenaufgabe.

Schreiben Sie eine beliebige Zahl, die nicht negativ und kleiner als zehntausend ist, auf einen Zettel. Schreiben Sie diese Zahl mit vier Ziffern, notfalls ergänzen Sie die Zahl um führende Nullen. Nun stellen Sie aus diesen vier Ziffern durch Umordnen die größtmögliche und die kleinstmögliche Zahl her. Nun bilden Sie die Differenz der beiden Zahlen. Diese neue Zahl bezeichnen wir als Folgezahl zur zunächst gewählten. Von dieser Zahl bilden wir nach derselben Vorgehensweise erneut die Folgezahl, und damit wieder und wieder. Falls wir mit 7777 starten liefert der Prozess diese Folge

7777 → 0000 → 0000.

Wir landen also bei der Zahl 0, was weiter kein Wunder ist. Interessant wird es, wenn wir anfangs eine Zahl mit nicht durchweg identischen Ziffern wählen, beispielweise 0021. Dann ergibt sich die Folge

0021 → 2088 → 8532 → 6174 → 6174 → …

Wir landen bei der Zahl 6174. Und das Sonderbare ist: Egal von welcher der 9990 möglichen Zahlen wir starten, immer wieder ergibt sich 6174. Die Zahl 6174 scheint eine wunderbare magische Anziehungskraft zu besitzen. Mancher Mathematiker hat sich davon narren lassen.

Entzauberung (wiederum für den mathematisch Interessierten): Wir fassen alle wesentlichen Zahlen zur Menge K0 zusammen. Von den Zahlen, die allein durch Umordnen der Ziffern entstehen, nehmen wir jeweils nur einen Repräsentanten in die Menge auf. Das sind dann insgesamt 715 Zahlen, also schon deutlich weniger als die zunächst eingebrachten zehntausend. Nun gehen wir zur Menge K1 der Repräsentanten der direkten Nachfolger dieser Zahlen über. Dann bilden wir die Menge K2 aller Nachfolger der Zahlen aus K1. Und so weiter. Es entsteht eine Folge von Mengen K0, K1, K2, … Die Rechenvorschrift für den Nachfolger bewirkt, dass jede Folgemenge ausschließlich Elemente der jeweiligen Vorgängermenge enthält, aber – und das ist der Witz – manchmal nur einen kleinen Teil davon.

In unserem Fall schrumpfen die Zahlenmengen ziemlich rasch von 715 auf 31, 18, 13, 9, 6, 3 und schließlich auf nur noch zwei Zahlen zusammen. K7 enthält nur noch die Repräsentanten der Zahlen 0 und 6174.

Es kann gar nicht ausbleiben, dass nach wenigen Schritten, hier sind es sieben, nur noch wenige Zahlen übrigbleiben und dass sich diese Zahlenmenge nicht weiter reduzieren lässt. Die letzte Menge muss ausschließlich Zyklen von Zahlen enthalten, bei denen die Nachfolgerbeziehung irgendwann auf die Ausgangszahl zurückführt. Solch ein Zyklus wird erwartungsgemäß ziemlich kurz sein, im Extremfall besteht er aus nur einem Element.

Bei den vierstelligen Dezimalzahlen sind das zwei Zyklen aus jeweils nur einer Zahl: 0000 und 6174. An der Zahl 6174 ist so besehen als überhaupt nichts magisch oder wunderbar.

Wenn man mit anderen Stellenzahlen und Basiswerten (Oktalsystem, Hexadezimalsystem) experimentiert, kommt man ebenfalls auf kleine Zyklen. Bei den zweistelligen Dezimalzahlen kommt man neben dem Nullzyklus noch auf den Zyklus aus fünf Zahlen:

09 → 18 → 36 → 45 → 27 → 09

Bei den zweistelligen Zahlen im Stellenwertsystem zur Basis sieben gibt es schließlich nur noch den 0-Zyklus: Egal mit welcher der 49 möglichen Zahlen man startet, stets landet man bei 00.

Erfindungen und Entdeckungen: Serendipity

Was für die meisten Leute ein Wunder ist (beispielsweise die Tatsache, dass die Lichtgeschwindigkeit eine obere Schranke für die Ausbreitung von Energie oder die Bewegung von Körpern darstellt), ist für den Physiker kein Wunder mehr. Aber auch er – und gerade er – begegnet immer neuen Wundern. Die Welt ist voller Wunder, einfach weil uns viele Wirkmechanismen nicht bekannt sind. Ob etwas ein Wunder ist oder nicht, hängt offenbar vom Wissensstand des Betrachters ab. Der Begriff des Wunders im dritten Sinne ist subjektiv und zeitabhängig.

Es ist ein Fehlschluss, wenn man meint, man könne solchen Wundern im Rahmen der massiven Forschungsförderung und mit riesigen Teams auf die Spur kommen. In meinem Artikel „Skeptiker“ kontra Skeptiker über Kreativität in der Wissenschaft“ gehe ich darauf ein.

Neue Lösungen und Entdeckungen werden keinesfalls in Teamarbeit und zielgerichtet angegangen. Der Geistesblitz ereignet sich stets in einem einzigen Kopf! Meist entdecken die Genies rein zufällig Lösungen für Probleme, die sie eigentlich gar nicht hatten. Und das ist wunderbar.

Diese Auffassung wird von vielen Autoren vertreten, die über das Wesen der Kreativität schreiben. Der Vorgang des Erfindens und Entdeckens wird in ihren Büchern meist anhand des Märchens der „drei Prinzen aus Serendip“ erläutert: Durch Zufall und Weisheit machen diese Drei unerwartete Entdeckungen. Diese Sicht der Dinge hat sogar Eingang in den angelsächsischen Wortschatz gefunden: Serendipity steht für glückliche Fügung, genauer: für die zufällige Beobachtung von etwas ursprünglich nicht Gesuchtem, das sich als neue und überraschende Entdeckung erweist.

Echokammern und Wunderverhinderung

Wer meint, gegen Wundervorstellungen ankämpfen zu müssen, gerät in zwei wesentliche Schwierigkeiten; die erste ist formaler Natur und die zweite betrifft die praktischen Konsequenzen.

- Wer übernatürliche Wunder als nichtexistent nachweisen will, muss sagen, was er unter einem solchen Wunder versteht. Und das wird ihm mit seinem komplett diesseitigen Instrumentarium nicht gelingen. Es gibt kein Kriterium für Ereignisse, die von einer Übernatur verursacht sind. Sie lassen sich nicht unterscheiden von Ereignissen, die noch nicht ausreichend untersucht worden sind und über deren Wirkmechanismen noch keine Erfahrungen vorliegen.

- Wer unter Wunder all das begreift, was der heutigen Naturwissenschaft und den bisherigen Erfahrungen widerspricht, wird blind für Neues, unempfindlich für das Wunderbare. Er schließt sich in eine Echokammer ein, die nur das widerhallen lässt, was er bereits gut kennt.

Der zweite Punkt scheint mir besonders wichtig zu sein. Er spiegelt den Zeitgeist der grassierenden Bequemlichkeit wieder. Wenn ich heute über das Internet ein Buch bestellen will, bekomme ich seitens Amazon bereits Kaufvorschläge, die auf den Spuren beruhen, die ich – insbesondere aufgrund meiner bisherigen Bestellungen und Wahlhandlungen – im Internet hinterlassen habe. Cass R. Sunstein hat sich mit diesen Fragen in seinem Buch „Choosing not to choose“ (2015) eingehend beschäftigt: “There is a risk to learning and development in any situation in which people are defaulted into a kind of echo chamber, even if they themselves took the initial step to devise it” (Seite 109). „The problem, in short, is that if defaults are based on such choices, the process of personal development might be stunted. When your experiences are closely tailored to your past choices, your defaults are personalized, which is highly convenient, but you will also be far less likely to develop new tastes, preferences, and values” (Seite 161).

Sunstein spricht von Standardregeln (default rules), die uns von der interessierten Wirtschaft auferlegt werden. Die so erzeugten Echokammern behindern unsere geistige Entwicklung.

Das Internet bietet eine nahezu grenzenlose Freiheit der Informationsgewinnung. Gleichzeitig geraten wir in ein neues Paradoxon: „Die moderne, durch hochverdichtete Netze zusammengebundene Industriegesellschaft […] lässt sich […] zentralistisch nicht mehr organisieren. Entsprechend wächst mit der Netzverdichtung und mit dem ihr entsprechenden Grad der Komplexität moderner Lebensverhältnisse unsere Angewiesenheit auf Formen lebendiger politischer Selbstorganisation nicht zuletzt in kleinen Einheiten und Kommunitäten“ (Hermann Lübbe in „Modernisierung und Folgelasten“, 1997, S. 20). Die homogene Massengesellschaft zerfällt in homogene abgeschottete Untermassen, die sich in ihre Echokammern einschließen.

Ein Muster dieses Isolierungsprozesses ist der Präsidentschaftswahlkampf 2004 in den USA. Erstmals wurde die politische Diskussion im großen Maßstab durch Blogs geprägt, sauber getrennt nach Red Believers (Republikaner um Präsident Bush) und Blue Believers (Demokraten um den Herausforderer Kerry). „Technology made it possible to nationalize the sense of community, help people find political soul mates and search for their personal truths online; but the political class also helped peel people apart. Both parties redrew districts to be more political homogeneous, marginalized their centrists, elevated their flamethrowers, viewed with suspicion anyone who sounded temperate or reached across the aisle.” (Time, September 27, 2004, p. 42)

Der Wissenschaftsgläubige, der das Wesen der Dinge zumindest partiell erkannt zu haben meint, macht etwas Ähnliches: Er setzt auf das bereits Bekannte und bildet sich seine eigene Echokammer. Das macht ihn unaufmerksam gegenüber dem überraschend Neuen. Und damit sind wir wieder bei unserem Ausgangspunkt angelangt: Die Fokussierung der Abwehr auf „übernatürliche Wunder“ — ein im Grunde sinnfreien Begriff — sorgt für gedankliche Enge.